Ollama - Guia Rápido de Instalação e Utilização com o Llama3 e Mistral

Ollama é uma ferramenta de código aberto que permite executar e gerenciar modelos de linguagem grande (LLMs) diretamente na sua máquina local. Isso significa que você pode usar modelos poderosos como o Llama 3 para gerar texto, traduzir idiomas e realizar outras tarefas complexas sem precisar depender de serviços em nuvem.

Llama3 é um modelo de linguagem grande (LLM) desenvolvido pela Meta AI, conhecido por sua capacidade de processar e entender a linguagem natural. Ele é treinado em uma enorme quantidade de dados de texto e código, o que permite que ele realize diversas tarefas, como: Geração de texto, Tradução de idiomas, Escrita criativa, Resposta a perguntas, Reconhecimento de imagens, Análise de sentimento, Codificação e muito mais... Mistral é um modelo de linguagem generativa de código aberto desenvolvido pela startup francesa Mistral AI. Ele se destaca por ser focado em aplicações de negócios, oferecendo recursos específicos para auxiliar empresas em diversas tarefas.01 - Passo

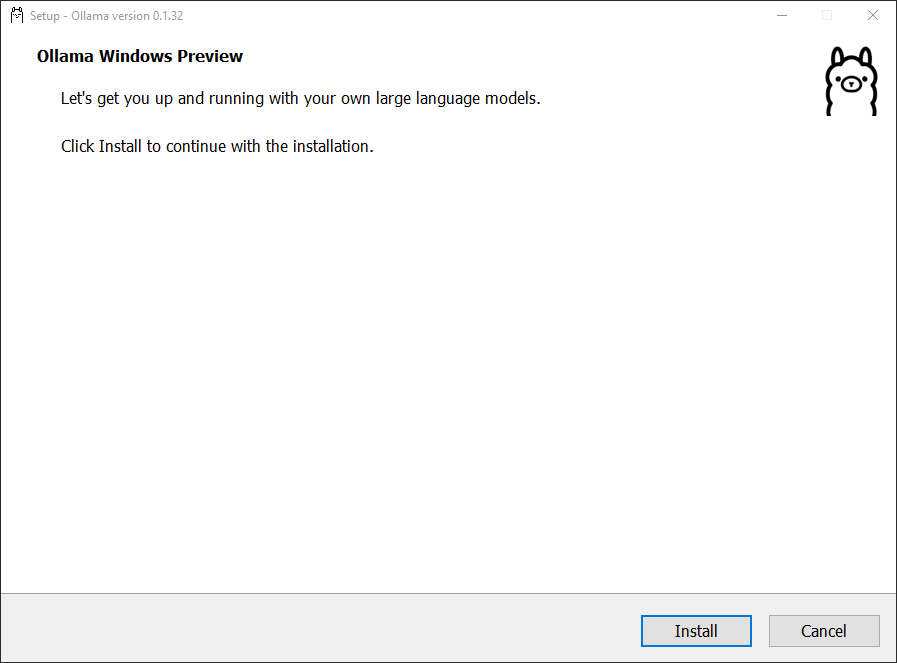

Realize o Download e a instalação do Ollama

02 - Passo

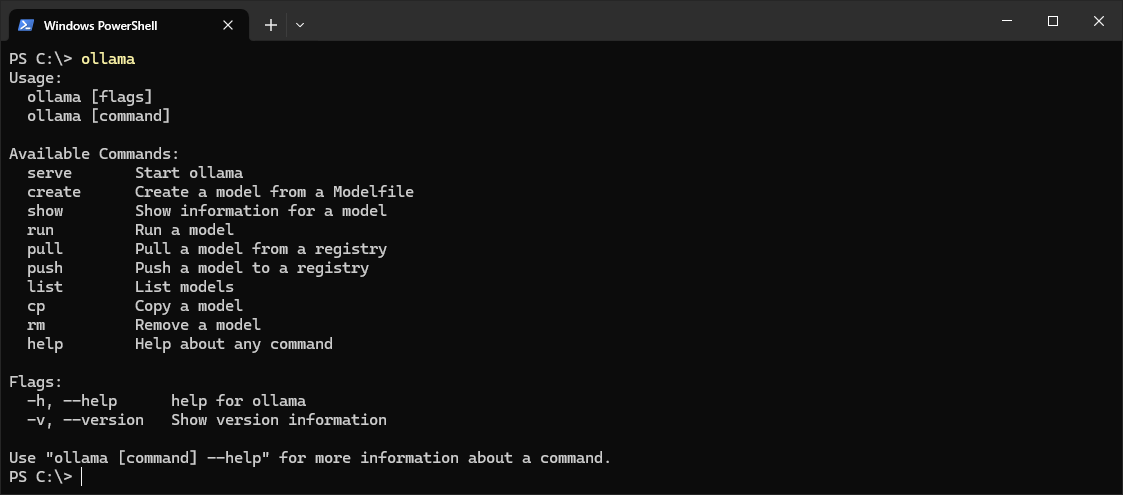

Execute o comando ollama para exibir todas as opções:

PowerShellPS C:\> ollama

03 - Passo

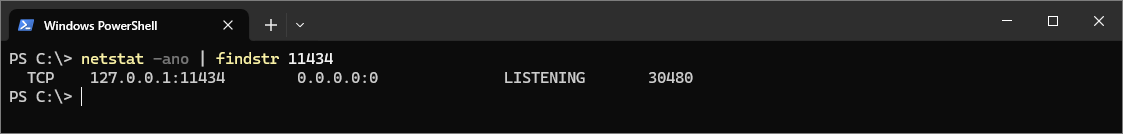

Verifique se a porta 11434 está aberta:

PowerShellPS C:\> netstat -ano | findstr 11434

04 - Passo

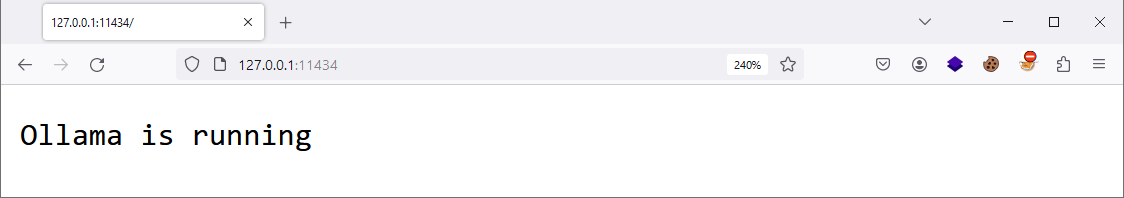

Abra o navegador e acesse: http://localhost:11434 ou http://127.0.0.1:11434 para confirmar se o serviço do Ollama foi iniciado com sucesso:

05 - Passo

Liste os modelos disponíveis:

PowerShellPS C:\> ollama list

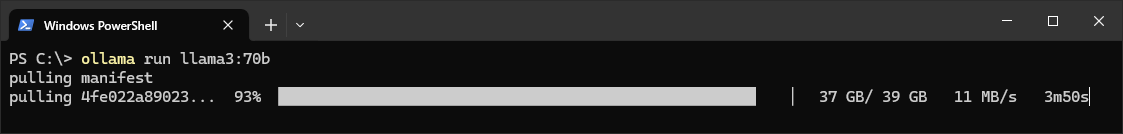

06 - Passo

Para utilizar outros modelos como por exemplo o Llama3:70b ou Llama3:70b-text , execute os comandos:

PowerShellPS C:\> ollama run llama3:70b PS C:\> ollama run llama3:70b-text

Observações adicionais sobre o modelo Llama3

🟢 Llama3:70b

- Treinado em um conjunto de dados mais abrangente, incluindo texto, código, imagens e áudio.

- Possui habilidades mais gerais, além da geração de texto, como:

- Reconhecimento de imagens: Pode identificar e classificar objetos em imagens.

- Análise de sentimento: Pode determinar o tom emocional de um texto.

- Codificação: Pode gerar código em diferentes linguagens de programação.

- Mais versátil e adaptável a uma gama mais ampla de tarefas.

🔵 Llama3:70b-text

- Treinado em um enorme conjunto de dados de texto e código, incluindo livros, artigos, código-fonte e outras formas de linguagem escrita.

- O foco principal está na geração de texto, tradução de idiomas, escrita de diferentes tipos de conteúdo criativo e resposta a perguntas de forma informativa.

- Ideal para tarefas que exigem compreensão profunda da linguagem e capacidade de gerar texto fluente e coerente.

Em resumo:

- Llama3:70b: Mais abrangente, com habilidades em diversas áreas, como reconhecimento de imagens, análise de sentimento e codificação.

- Llama3:70b-text: Especialista em geração de texto e tarefas que exigem compreensão profunda da linguagem.

Considerações adicionais:

- Ambos os modelos são grandes e exigem hardware potente para serem executados.

- O Llama3:70b é ainda maior e mais lento que o Llama3:70b-text.

- É importante experimentar os dois modelos para ver qual funciona melhor para suas necessidades específicas.

Links úteis:

- Meta Llama 3: https://llama.meta.com/llama3

- Llama3:70b: https://huggingface.co/meta-llama/Meta-Llama-3-70B

- Llama3:70b-text: https://huggingface.co/meta-llama/Meta-Llama-3-70B

- Llama-3-8B & Llama-3-70B: https://anakin.ai/blog/llama3-8b-llama3-70b

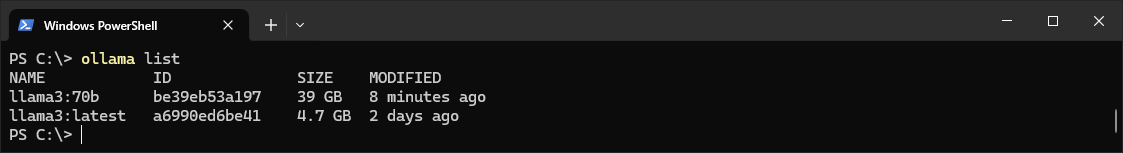

07 - Passo

Confirme se o modelo llama3:70b está disponível

PowerShellPS C:\> ollama list

Utilizando o LLama3:70b

01 - Passo

Execute o comando abaixo para utilizar o modelo llama3:70b , em seguida informa o parâmetro /? para conhecer as opções disponíveis no modelo.

PowerShellPS C:\> ollama run llama3:70b >>> /?

02 - Passo

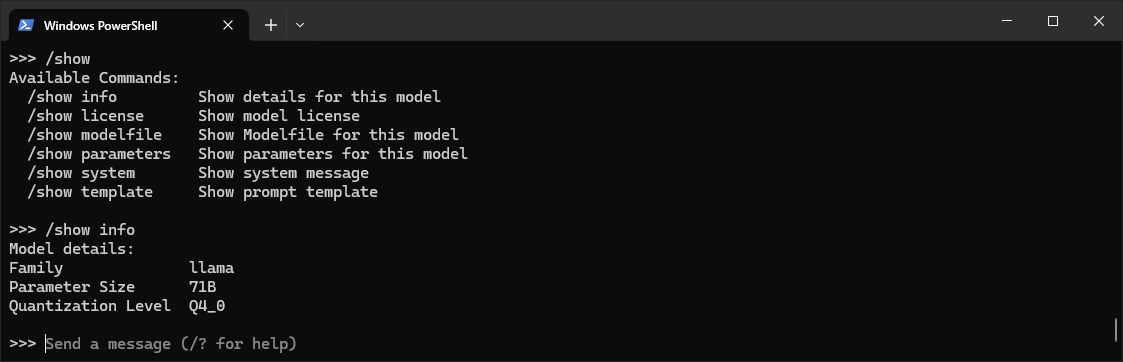

Utilize os parâmetros disponíveis para explorar o modelo, exemplo:

PowerShell>>> /show >>> /show info

03 - Passo

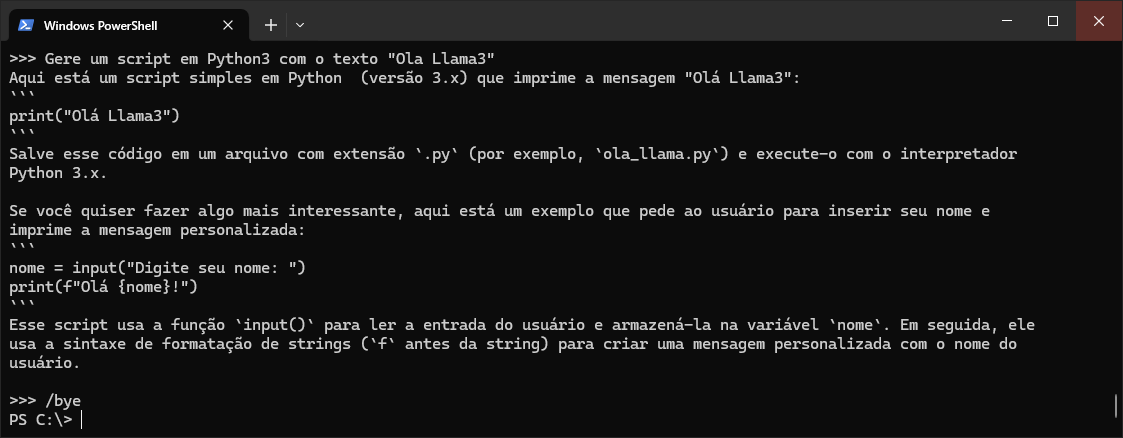

Agora basta interagir com o Llama3 para obter as respostas.

Para sair execute o comando /bye

PowerShell>>> Gere um script em Python3 com o texto "Ola Mistral" >>> /bye

Utilizando o modelo Mistral através do arquivo GGUF

O que são arquivos GGUF?

GGUF , sigla para GPT-Generated Unified Format, é um formato de arquivo padronizado para armazenar grandes modelos de linguagem (LLMs) para inferência. Ele foi desenvolvido pela Hugging Face e oferece diversas vantagens, como:

- Eficiência: O GGUF utiliza compactação eficiente para reduzir o tamanho do arquivo, facilitando o download e o armazenamento.

- Padronização: O formato padronizado permite que os LLMs sejam facilmente carregados e usados em diferentes ferramentas e frameworks.

- Flexibilidade: O GGUF suporta diversos tipos de LLMs, incluindo modelos de texto, código e imagem.

Como usar arquivos GGUF no Ollama?

- Acesse o site da Hugging Face [ huggingface.co/models ] e procure o modelo LLM desejado

- Verifique se o modelo está disponível no formato GGUF.

- Baixe o arquivo GGUF para o seu computador.

01 - Passo

Realize o download de um Modelo , exemplo: Mistral.

Crie um arquivo de texto chamado Modelfile no diretório onde você deseja executar o modelo.

No arquivo Modelfile, adicione a seguinte linha:

NotepadFROM ./nome_do_arquivo_GGUF.gguf

02 - Passo

Entre na pasta onde você deixou o Modelo e o arquivo Modelfile e execute o comando:

PowerShellPS C:\Users\Marcos> cd .\Downloads\ PS C:\Users\Marcos\Downloads> ollama create Mistral -f .\Modelfile

03 - Passo

Execute o comando abaixo para confirmar se o Modelo foi carregado com sucesso.

PowerShellPS C:\Users\Marcos\Downloads> ollama list

04 - Passo

Para utilizar o modelo Mistral , execute o comando:

PowerShellPS C:\> ollama run Mistral

São Paulo/SP

São Paulo/SP